Address

304 North Cardinal St.

Dorchester Center, MA 02124

Work Hours

Monday to Friday: 7AM - 7PM

Weekend: 10AM - 5PM

2023 年第 3 季度:此模型卡代表了公开的 GPT-4 模型研究的综合成果——在此分析中,我们站在巨人的肩膀上(并汇总了他们的数据点)。

GPT-4 代表了大型语言模型功能的重大飞跃。它由 OpenAI 开发,建立在 GPT-3 的架构和优势之上,同时实现了新的规模和性能水平。

OpenAI 的 GPT-4 目标是创建一个比 GPT-3 大 10 倍以上的模型。这不仅需要更大的训练计算能力,还需要全新的模型架构和推理服务方法。

有关 GPT-4 的一些关键事实:

使用前请仔细检查 GPT-4 输出,因为如果没有适当的监督,该模型可能会生成有害、有偏见或事实上不正确的文本。

| 范围 | 细节 |

|---|---|

| 组织 | 开放人工智能 |

| 型号名称 | GPT-4 |

| 型号类型 | 专家混合的变压器 |

| 参数 | 1.8万亿 |

| 上下文窗口 | 8-32,000 个代币 |

| 发射日期 | 2023 年 3 月 |

| 当前版本 | 1.1(版本 06.13) |

| 训练数据集 | 13 万亿代币(网络文本、书籍、其他) |

| 计算 | 细节 |

|---|---|

| 训练 | 25,000 个 Nvidia A100 GPU 上的 90 天 |

| 推理 | 128个A100 GPU集群 |

| 范围 | 细节 |

|---|---|

| 数据源 | CommonCrawl、WebText2、书籍、维基百科、Reddit、亚马逊评论 |

| 数据量 | 约 13 万亿代币 |

| 数据准备 | 去重、清理、过滤 |

| 潜在的偏见 | 语言、性别、种族代表性 |

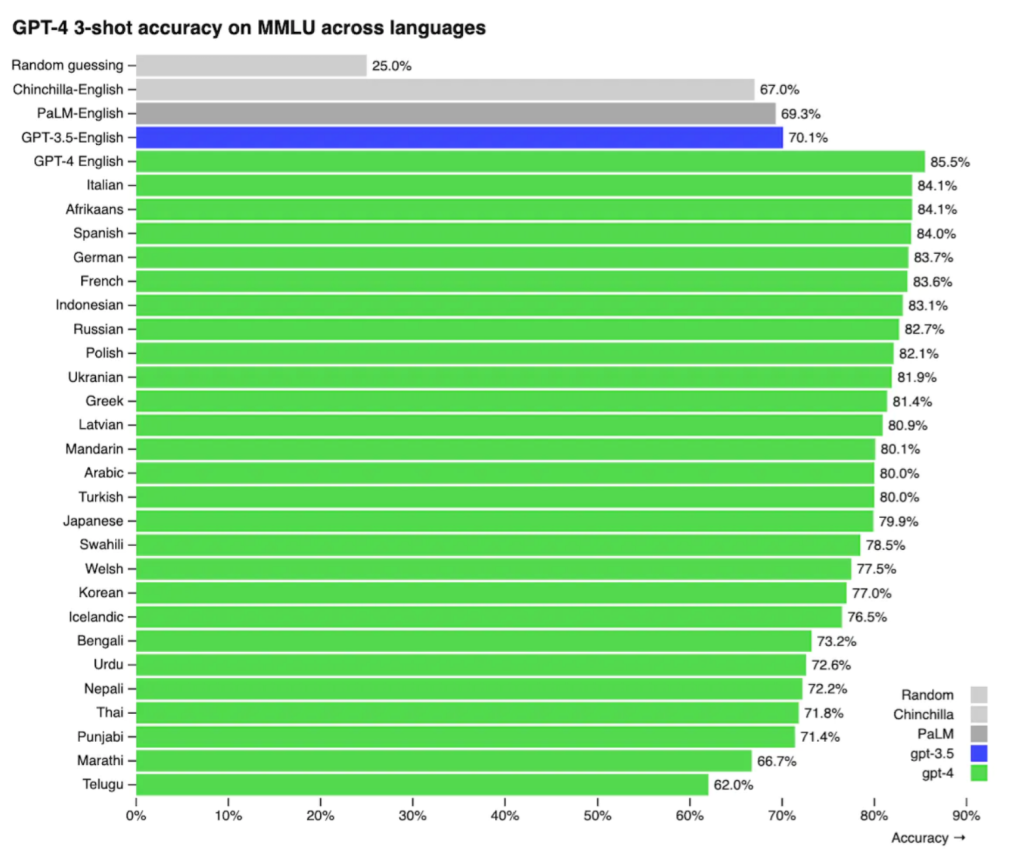

GPT-4 在 MMLU 基准测试的 26 种不同语言的翻译版本上进行了测试。在测试的 26 种语言中,它在 24 种语言中的表现优于 GPT-3.5 和其他法学硕士,其中包括拉脱维亚语、威尔士语和斯瓦希里语等资源匮乏的语言。Datacamp 和 MakeUseOf 文章还指出了 GPT-4 的多语言功能,支持英语、法语、德语、西班牙语、中文、日语、韩语等之间的翻译。Translated Labs 指出,由于英语在训练数据中占主导地位,GPT-4 在英语和其他语言之间的性能存在差异。他们的 T-LM 产品通过翻译提示来帮助解决这个问题,以增强 GPT-4 的 200 种语言的功能。

GPT-4 可能会被滥用并产生有害的社会影响。使用前仔细检查输出。不要将其视为事实陈述。如有疑问或疑虑,请联系safety@openai.com

GPT-4 的模型架构不再采用标准的 Transformer 方法。相反,它采用了专家 (MoE) 混合设计。

在 MoE 架构中,有专门处理某些任务或数据类型的单独的专家神经网络。对于每个推理查询,选择适当的专家模型来处理该特定输入。

这提供了两个主要优点:

具体来说,GPT-4 包括:

顶部提示

这种架构很可能会阻止真正的温度 0 设置,从而导致由采样和路由到专家混合引起的推理方差。此外,CUDA 驱动程序浮点运算是非相加的。这一理论在 2023 年 9 月与 Stephen Wolfram 的 1:1 讨论中得到证实。

这种架构允许 GPT-4 总共达到超过 1.8 万亿个参数,而每个查询仅使用数千亿个参数。

训练像 GPT-4 这样大的模型需要大量的计算资源。它突破了现有基础设施的限制。

有关 GPT-4 训练过程的关键事实:

为了实现这一点,使用了广泛的并行技术:

结果是人工智能模型有史以来最大的计算工作之一。

由于其规模和专家架构的混合,大规模部署 GPT-4 进行推理是一项重大挑战。高效的推理直接影响成本。

有关 GPT-4 推理的关键事实:

推理集群旨在最大限度地提高吞吐量和硬件利用率。这可以降低每次查询的成本。

针对不同专家模型的一致批处理查询仍然存在挑战。但总体而言,基础设施可以有效部署 GPT-4,且价格不会过高。

GPT-4 中使用的专家混合 (MoE) 架构依赖于令牌路由机制来确定哪些专家处理每个令牌。这可能会导致某些令牌被“丢弃”或未处理。

GPT-4 使用简单的 top-2 令牌路由方法,其中每个令牌根据路由器发送给 2 个最有可能的专家。专家本身对每批可以处理的代币数量有一定的限制。

当跨长输入序列和大批量进行聚合时,通常会超出专家容量,导致令牌被丢弃。与直觉相反,一定程度的丢弃实际上有利于模型性能和效率,因为它可以防止专家过载。

掉落是不确定的 – 运行相同的提示两次可能会导致每次不同的掉落。这是因为根据容量,不同批次的代币掉落情况有所不同。模型本身仍然是确定性的。

虽然 OpenAI 可以调整专家能力并减少丢失,但这将大大增加推理时间和成本。当前的权衡可以实现廉价的大规模部署。掉落是稀疏 MoE 设计所固有的。

了解路由如何导致丢弃可以深入了解 GPT-4 中的随机性观察。掉落因用途而异,但模型逻辑本身却没有。

GPT-4 在语言模型基础方面取得了令人瞩目的进展。然而,未来的模型可能需要扩展到纯粹基于文本的方法之外。

未来的一些重点领域:

每一代,OpenAI 都在向通用人工智能迈进。虽然他们比任何其他法学硕士/人工智能研究公司都走得更远,但我们距离真正的通用智能还很远,缺乏诸如意志、决策、记忆、实时知识合成和其他属性等关键属性。

GPT-4 展示了语言模型的快速进步。虽然我们距离通用智能还很远,但 OpenAI 会通过每次新的迭代继续推动这一目标。令人兴奋的能力可能就在前方。